En el marco de la “Premier sobre Centros de Datos e IA” AMD anunció los productos, la estrategia y los socios del ecosistema que darán forma al futuro del cómputo, destacando la próxima fase de innovación de los centros de datos. En el escenario, AMD se unió con ejecutivos de Amazon Web Services (AWS), Citadel, Hugging Face, Meta, Microsoft Azure y PyTorch para mostrar las alianzas tecnológicas con líderes de la industria para llevar al mercado la próxima generación de soluciones de CPU de alto rendimiento y aceleradores de IA.

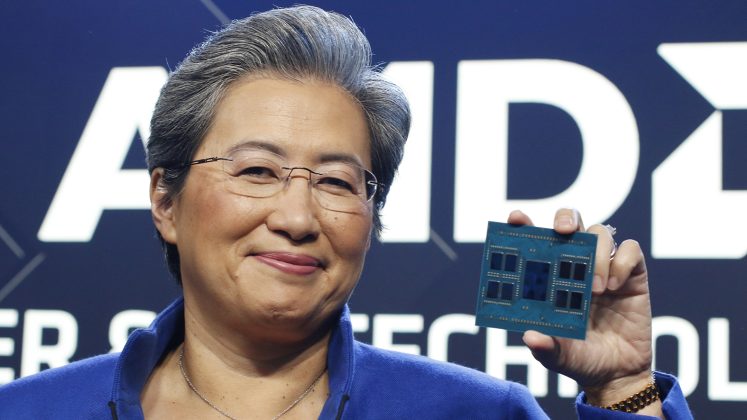

«Hoy hemos dado otro paso significativo en nuestra estrategia de centros de datos al ampliar nuestra familia de procesadores EPYC de 4ª Generación, con nuevas soluciones de liderazgo para cargas de trabajo de cómputo técnico y en la nube, y hemos anunciado nuevas instancias públicas y despliegues internos con los mayores proveedores de cloud», dijo la presidenta y CEO de AMD, Lisa Su.

«La IA es la tecnología definitoria que da forma a la próxima generación de cómputo y la mayor oportunidad de crecimiento estratégico para AMD. Estamos centrados como un láser en acelerar el despliegue de las plataformas de IA de AMD a escala en los centros de datos, liderados por el lanzamiento de nuestros Aceleradores Instinct MI300, previsto para finales de este año, además del creciente ecosistema de software de IA que ya está listo para las empresas y optimizado para nuestro hardware”.

Infraestructura informática optimizada para el Centro de Datos moderno

AMD presentó una serie de actualizaciones de su familia EPYC de 4ª Generación, diseñadas para ofrecer a los clientes la especialización de cargas de trabajo necesaria para satisfacer las necesidades únicas de las empresas.

El avance del CPU para centro de datos

AMD recalcó cómo la 4ª Generación de procesadores AMD EPYC continúa impulsando el liderazgo en rendimiento y eficiencia energética. AMD se unió a AWS para destacar una vista previa de la próxima generación de instancias Amazon Elastic Compute Cloud (Amazon EC2) M7a, impulsadas por procesadores AMD EPYC de 4ª Generación («Genoa»). Por fuera del evento, Oracle anunció sus planes de poner a disposición nuevas instancias Oracle Computing Infrastructure (OCI) E5 con procesadores AMD EPYC de 4ª Generación.

Computo nativo en la nube sin compromisos

AMD presentó los procesadores de 4ª Generación AMD EPYC 97X4, antes llamados «Bergamo». Con 128 núcleos «Zen 4c» por zócalo, estos procesadores proporcionan la mayor densidad de vCPU y un rendimiento líder en la industria para aplicaciones que se ejecutan en la nube, y eficiencia energética de liderazgo. AMD se unió a Meta, que habló sobre cómo estos procesadores son adecuados para sus aplicaciones principales, como Instagram, WhatsApp y más; cómo están viendo impresionantes ganancias de rendimiento con los procesadores AMD EPYC 97×4 de 4ª Generación, en comparación con los AMD EPYC de 3ª Generación en varias cargas de trabajo, cómo se ofrecen mejoras sustanciales en el coste total de propiedad y, cómo AMD y Meta optimizaron las CPU EPYC para los requisitos de eficiencia energética y densidad de computación de la compañía.

Permitiendo mejores productos con cómputo técnica

AMD presentó los procesadores AMD EPYC de 4ª Generación con tecnología AMD 3D V-Cache, la CPU de servidor x86 de mayor rendimiento del mundo para cómputo técnica. Microsoft anunció la disponibilidad general de las instancias Azure HBv4 y HX, impulsadas por procesadores AMD EPYC de 4ª Generación con tecnología AMD 3D V-Cache.

Plataforma de IA de AMD – La visión omnipresente de la IA

AMD presentó una serie de anuncios que muestran su estrategia de plataforma de IA, que ofrece a los clientes una cartera de productos de hardware de la nube, al extremo y al punto final, con una profunda colaboración de software de la industria, para desarrollar soluciones de IA escalables y omnipresentes.

El acelerador de IA generativa más avanzado del mundo

AMD reveló nuevos detalles de la familia de aceleradores AMD Instinct Serie MI300, incluyendo la presentación del acelerador AMD Instinct MI300X, uno de los más avanzado del mundo para IA generativa. El MI300X se basa en la arquitectura de acelerador AMD CDNA 3 de última generación, y admite hasta 192 GB de memoria HBM3 para proporcionar la eficiencia de cómputo y memoria necesaria para el entrenamiento e inferencia de modelos de lenguaje de gran tamaño y para cargas de trabajo de IA generativa. Gracias a la gran capacidad de memoria de AMD Instinct MI300X, los clientes pueden instalar modelos de lenguaje de gran tamaño, como Falcon-40, un modelo de 40B parámetros, en un único acelerador MI300X. AMD también presentó la plataforma AMD Instinct, que reúne ocho aceleradores MI300X en un diseño estándar del sector para ofrecer la solución definitiva para la inferencia y el entrenamiento de IA. El MI300X se distribuirá a clientes clave a partir del tercer trimestre. AMD también dio a conocer AMD Instinct MI300A, el primer acelerador APU del mundo para cargas de trabajo HPC e IA, que ya está disponible para los clientes.

Plataforma de software de IA abierta, comprobada y disponible

AMD presentó el ecosistema de software ROCm para aceleradores de centros de datos, destacando la preparación y las colaboraciones con líderes del sector para reunir un ecosistema de software de IA abierto. PyTorch discutió el trabajo entre AMD y la Fundación PyTorch para actualizar completamente la pila de software ROCm, proporcionando soporte inmediato «día cero» para PyTorch 2.0 con la versión 5.4.2 de ROCm, en todos los aceleradores AMD Instinct. Esta integración ofrece a los desarrolladores una amplia gama de modelos de IA basados en PyTorch, que son compatibles y están listos para su uso en los aceleradores AMD. Hugging Face, la plataforma abierta líder para desarrolladores de IA anunció que optimizará miles de modelos de Hugging Face en plataformas AMD, desde aceleradores AMD Instinct hasta Procesadores AMD Ryzen y AMD EPYC, GPU AMD Radeon y procesadores adaptativos Versal y Alveo.

Una sólida línea de productos de conectividad para la nube y la empresa

AMD presentó una sólida cartera de productos de conectividad que incluye la DPU AMD Pensando, las NIC de latencia ultrabaja AMD y las NIC adaptativas AMD. Además, las DPU AMD Pensando combinan una sólida pila de software con «seguridad de confianza cero» y un procesador de paquetes programable de liderazgo para crear la DPU más inteligente y con mayor rendimiento del mundo. La DPU AMD Pensando se despliega a escala a través de socios en la nube como IBM Cloud, Microsoft Azure y Oracle Compute Infrastructure. En la empresa se despliega en HPE Aruba CX 10000 Smart Switch, y con clientes como la empresa líder de servicios de TI DXC, y como parte de VMware vSphere Distributed Services Engine, acelerando el rendimiento de las aplicaciones para los clientes.

AMD también destacó la próxima generación de su hoja de ruta de DPU, cuyo nombre en clave es «Giglio», cuyo objetivo es ofrecer a los clientes un mayor rendimiento y eficiencia energética, en comparación con los productos de la generación actual, cuando llegue al mercado a finales de 2023.

AMD también anunció el kit de desarrollo de software en silicio AMD Pensando (SSDK), que ofrece a los clientes la posibilidad de desarrollar o migrar rápidamente servicios para implementarlos en la DPU programable AMD Pensando P4, en coordinación con el rico conjunto de funciones ya implementadas en la plataforma AMD Pensando. El AMD Pensando SSDK permite a los clientes poner la potencia del liderazgo de la DPU AMD Pensando a trabajar y adaptar la virtualización de red y las características de seguridad, dentro de su infraestructura y en coordinación con el rico conjunto existente de características ya implementadas en la plataforma Pensando.