Intel le dio la bienvenida a la siguiente ola de inteligencia artificial (IA), con actualizaciones de nuevos productos, diseñados para acelerar el desarrollo del sistema de inteligencia artificial y la implementación desde el cloud to edge.

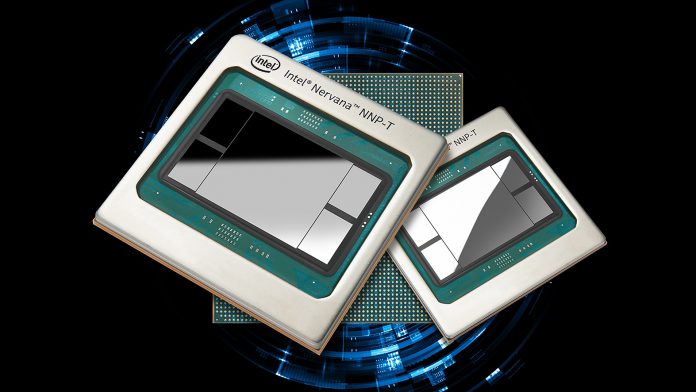

El fabricante hizo una demostración de sus procesadores de redes neuronales Intel Nervana (NNP) para entrenamiento (NNP-T1000) e inferencia (NNP-I1000) — los primeros ASIC (circuitos integrados de aplicación específica por sus siglas en inglés) de Intel, construidos especialmente para el aprendizaje profundo complejo, con una escala y eficiencia increíbles para los clientes de la nube y del centro de datos. Intel también dio a conocer su unidad de procesamiento de visión (VPU) Intel Movidius Myriad para aplicaciones de medios perimetrales, visión por computadora e inferencia.

“Con esta siguiente etapa de la inteligencia artificial, estamos llegando a un punto de inflexión en términos del hardware y la memoria computacional. El hardware especialmente diseñado, como el caso de los NNP Intel Nervana y las VPU Movidius Myriad, es necesario para continuar con el increíble progreso de la Inteligencia Artificial. Usar formas más avanzadas de inteligencia artificial a nivel de sistema, nos ayudará a pasar de la conversión de datos en información, a la transformación de la información en conocimiento”, dijo, Naveen Rao, vicepresidente Corporativo de Intel y gerente general del Grupo de Productos de Inteligencia Artificial de Intel.

Estos productos siguen fortaleciendo la cartera de soluciones de inteligencia artificial de Intel, que se espera que genere ingresos de más de US$ 3.5 mil millones de dólares en 2019. La cartera de inteligencia artificial de Intel ayuda a que los clientes habiliten el desarrollo e implementación de modelos de inteligencia artificial a cualquier escala, desde nubes masivas hasta los pequeños dispositivos perimetrales, y todo lo que hay en medio.

El anuncio

Los nuevos NNP Intel Nervana, que ahora están en producción y entregándose a los clientes, son parte de una propuesta de inteligencia artificial a nivel de sistemas, que ofrece una pila de software completa desarrollada con componentes abiertos y una integración de marco de aprendizaje profundo para un uso máximo.

El NNP-T Intel Nervana logra el equilibrio adecuado entre el cómputo, la comunicación y la memoria, permitiendo un escalamiento casi lineal y de bajo consumo, desde los pequeños clústeres hasta las supercomputadoras Pod más grandes. El NNP-I Intel Nervana es eficiente en términos de energía y presupuesto, e ideal para ejecutar inferencias intensas y multimodales a escala real, utilizando factores de forma flexibles. Ambos productos fueron desarrollados para las necesidades de procesamiento de Inteligencia Artificial de vanguardia de los clientes como Baidu y Facebook.

“Estamos entusiasmados de trabajar con Intel para implementar un cálculo de inferencia más rápido y eficiente con el procesador de red neuronal Intel Nervana para inferencia (NNP-I) y extender el soporte para nuestro compilador de aprendizaje profundo de última generación, Glow, al NNP-I”, manifestó Misha Smelyanskiy, directora de Codiseño del Sistema de Inteligencia Artificial en Facebook.

Asimismo, la VPU Intel Movidius de próxima generación de Intel, cuya disponibilidad está programada para el primer semestre de 2020, incorporará avances únicos, altamente eficientes, que se espera que ofrezcan un rendimiento único en el mercado—un desempeño de inferencia más de 10 veces mejor que la generación anterior—con seis veces más eficiencia energética que los procesadores competidores. Intel también anunció su nuevo Intel DevCloud for the Edge, que junto con el kit de herramientas Intel Distribution of OpenVINO, aborda una aflicción fundamental de los desarrolladores, al permitirles tratar y probar las soluciones de Inteligencia Artificial y crear prototipos de éstas en una amplia gama de procesadores Intel, antes de que compren el hardware.

Importancia

Se necesitan datos, modelos y técnicas increíblemente complejas para hacer progresos en el razonamiento y el contexto del aprendizaje profundo, lo que deriva en la necesidad de pensar de forma diferente sobre las arquitecturas.

Con la mayor parte del mundo ejecutando una parte de su inteligencia artificial en procesadores Intel Xeon Scalable, Intel continúa mejorando esta plataforma con características como Intel Deep Learning Boost, con instrucciones de redes neuronales vectoriales (VNNI) que brindan un mejor rendimiento de inferencia de inteligencia artificial, mejorado en los centros de datos y en las implementaciones de Edge. Si bien eso continuará sirviendo como base sólida de la inteligencia artificial durante años, las necesidades de capacitación de aprendizaje profundo más avanzado para los clientes de Intel requieren que el desempeño se duplique cada 3.5 meses, y esa clase de progresos solo se llevarán a cabo con un portafolio de soluciones de inteligencia artificial como el de Intel.