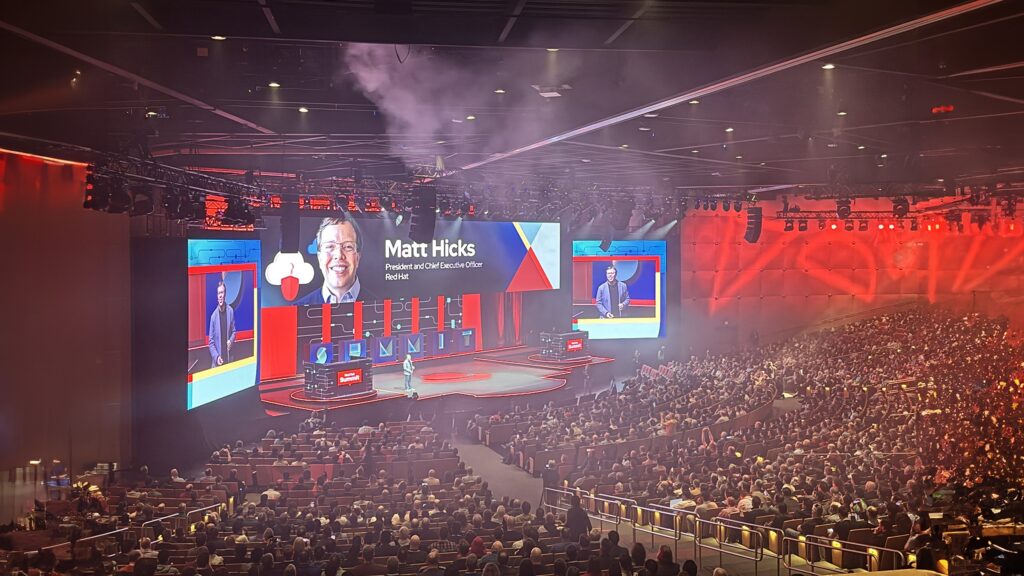

Durante cuatro días, del lunes seis al jueves nueve de mayo, Red Hat atendió a sus clientes y socios de negocios en el Red Hat Summit 2024 desarrollado en Denver, EE.UU. En el evento, la compañía realizó importantes anuncios y su compromiso de impulsar el aprovechamiento de la IA en las organizaciones y su trabajo con el canal.

Los ejecutivos de Red Hat destacaron que el ecosistema de canales en Latinoamérica es fundamental para llegar a los clientes y poder ofrecerle la mejor solución para potenciar sus negocios. Son canales especializados en industrias y que conocen los modelos de negocios de los clientes.

Los canales de Red Hat en la región están preparados para atender los requerimientos de los clientes. Este ecosistema no está conformado por un gran grupo, sino por socios enfocados y que conocen el potencial del portafolio de Red Hat.

Destacaron que en América Latina la compañía está muy bien y que los resultados del 2023 fueron muy buenos, y que ven el futuro muy promisorio por el talento humano y el compromiso de los socios de negocios, y también porque las empresas están convencidas de que la tecnología es clave para seguir creciendo de manera competitiva y segura.

Anuncios

Red Hat anunció el lanzamiento de Red Hat Enterprise Linux AI (RHEL AI), una plataforma de modelos fundacionales que permite a los usuarios desarrollar, probar e implementar modelos de IA generativa (GenAI) de manera más integrada. RHEL AI combina la familia de modelos de lenguaje de gran tamaño (LLM) Granite con licencia open source de IBM Research, las herramientas de alineación de modelos InstructLab basadas en la metodología LAB (Large-scale Alignment for chatBots) y un enfoque para el desarrollo de modelos impulsado por la comunidad a través del proyecto InstructLab. La solución completa se ofrece empaquetada como una imagen de RHEL de inicio optimizada para implementaciones de servidores individuales en toda la nube híbrida y también como parte de OpenShift AI, la plataforma híbrida de operaciones de aprendizaje automático (MLOps) de Red Hat, para ejecutar modelos e InstructLab a escala en entornos de clústeres distribuidos.

“La GenAI constituye un avance revolucionario para las empresas, pero sólo si las organizaciones de tecnología son capaces de implementar y utilizar los modelos de IA de una forma que se ajuste a sus necesidades empresariales específicas. RHEL AI y el proyecto InstructLab, junto con Red Hat OpenShift AI a escala, se concibieron con el objeto de reducir muchas de las barreras que enfrenta la GenAI en toda la nube híbrida, desde el déficit de habilidades en ciencia de datos hasta la cantidad de recursos requeridos, mientas impulsan la innovación tanto en las implementaciones empresariales como en las comunidades de desarrollo”, indicó Ashesh Badani, Senior Vice President and Chief Product Officer de Red Hat.

“La GenAI constituye un avance revolucionario para las empresas, pero sólo si las organizaciones de tecnología son capaces de implementar y utilizar los modelos de IA de una forma que se ajuste a sus necesidades empresariales específicas. RHEL AI y el proyecto InstructLab, junto con Red Hat OpenShift AI a escala, se concibieron con el objeto de reducir muchas de las barreras que enfrenta la GenAI en toda la nube híbrida, desde el déficit de habilidades en ciencia de datos hasta la cantidad de recursos requeridos, mientas impulsan la innovación tanto en las implementaciones empresariales como en las comunidades de desarrollo”, indicó Ashesh Badani, Senior Vice President and Chief Product Officer de Red Hat.

La implementación de una estrategia de IA exige algo más que la simple elección de un modelo. Además de solventar los grandes costos de implementar la IA, las empresas tecnológicas requieren de conocimientos especializados para adaptar un modelo determinado a un caso de uso específico. Al déficit de habilidades en ciencia de datos se le suman importantes requisitos financieros, entre ellos:

- La adquisición de infraestructura de IA o el consumo de servicios de IA.

- El complejo proceso de adaptar los modelos de IA a necesidades empresariales específicas.

- La integración de la IA en las aplicaciones empresariales.

- La gestión del ciclo de vida tanto de las aplicaciones como de los modelos.

Ganadores de la 18ª edición anual de los Red Hat Innovation Awards

Desde el año 2006, en los Red Hat Innovation Awards se reconoce los logros tecnológicos de clientes de Red Hat de todas partes del mundo que exhiben una resolución creativa de los problemas con un impacto positivo en el universo empresarial y la sociedad. Los ganadores de este año son Banco de la Amazonía, Eusko Jaurlaritzaren Informatika Elkartea (EJIE), Informationstechnikzentrum Bund (Capgemini) y Transpower New Zealand.

Plataforma de El Capitán

Durante el evento, la compañía anunció que Red Hat Enterprise Linux será la plataforma de sistema operativo de El Capitán, la primera supercomputadora a exaescala de la National Nuclear Security Administration’s (NNSA). El Capitán, que se proyecta como la supercomputadora más potente del mundo, está alojada en el Lawrence Livermore National Laboratory (LLNL). Enterprise Linux, que actúa como catalizador de la pila de software de El capitán, proporciona un vínculo fundamental para dotar a las supercomputadoras habilitadas para la nube de componentes de inteligencia artificial (IA) y aprendizaje automático (ML).

OpenShift AI extiende la flexibilidad de la IA predictiva y generativa a toda la nube híbrida

OpenShift AI es una plataforma híbrida abierta de inteligencia artificial y aprendizaje automático (ML), que permite a las empresas crear y entregar aplicaciones basadas en IA a gran escala en la nube híbrida. En el evento, Red Hat que se vienen aplicando distintas actualizaciones que acentúan la visión de Red Hat de la IA y llevan el compromiso de la compañía con la libertad de elección del cliente al universo de las cargas de trabajo inteligentes, desde el hardware subyacente hasta los servicios y las herramientas que se utilizan para crear sobre la plataforma.

Esto contribuye a acelerar la innovación, a mejorar la productividad y la capacidad de incorporar la IA en las operaciones comerciales diarias a través de una plataforma open source más flexible, escalable y adaptable que permite tanto modelos predictivos como generativos, con o sin el uso de entornos de nube.

Al pasar los modelos de IA de la experimentación a producción, los clientes se enfrentan a muchos retos, que incluyen mayores costos de hardware, inquietudes respecto de la privacidad de los datos y falta de confianza a la hora de compartir sus datos con modelos basados en SaaS. La IA generativa (IA gen) evoluciona rápidamente y a muchas organizaciones les resulta difícil crear una plataforma central de IA confiable capaz de ejecutarse en modo local o en la nube.

Según IDC, para que puedan aprovechar la IA con éxito, las empresas necesitarán modernizar muchas de sus aplicaciones y entornos de datos existentes, eliminar obstáculos entre sus actuales sistemas y plataformas de almacenamiento, mejorar la sostenibilidad de la infraestructura y elegir con cuidado dónde implementar diferentes cargas de trabajo en la nube, el centro de datos y el edge. Para Red Hat, esto es indicativo de que las plataformas de IA deben ser flexibles para poder apoyar a las empresas a medida que avanzan en la adopción de la IA y van adaptando sus necesidades y recursos.

La estrategia de IA de Red Hat aporta flexibilidad en toda la nube híbrida, brinda la capacidad de mejorar los modelos básicos previamente entrenados o seleccionados con los datos de los clientes y la libertad de habilitar diversos aceleradores de hardware y software. Las características nuevas y mejoradas de Red Hat OpenShift AI cubren estas necesidades al brindar acceso a las últimas innovaciones en AI/ML y al soporte de un extenso ecosistema de partners centrado en AI. La última versión de la plataforma ofrece lo siguiente:

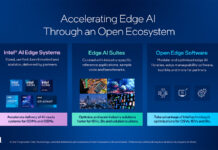

Servicio de modelos en el edge, que extiende la implementación de modelos de IA a ubicaciones remotas mediante OpenShift de un solo nodo. Proporciona capacidades de inferencia en entornos con recursos limitados con acceso a la red intermitente o aislado. Esta función en versión tecnológica preliminar proporciona a las empresas una experiencia operativa uniforme y escalable desde el núcleo hasta la nube y el edge e incluye observabilidad lista para usar.

Servicio de modelos mejorado, con la capacidad de utilizar múltiples servidores de modelos que admiten tanto la IA predictiva como la generativa e incluye soporte para KServe, una definición de recursos personalizada de Kubernetes que orquesta el servicio de toda clase de modelos, vLLM y servidor de inferencia de generación de texto (TGIS), motores de servicio para LLM y tiempo de ejecución Caikit-nlp-tgis, que maneja modelos y tareas de procesamiento de lenguaje natural (NLP). El servicio de modelos mejorado permite a los usuarios ejecutar IA predictiva y generativa en una única plataforma para múltiples casos de uso, lo cual reduce costos y simplifica las operaciones. Esto permite un servicio de modelos listo para usar para LLM y simplifica el flujo de trabajo del usuario.

Cargas de trabajo distribuidas con Ray, mediante el uso de CodeFlare y RayKube, que utilizan múltiples nodos de clúster para lograr un procesamiento de datos y un entrenamiento de modelos más rápidos y eficientes. Ray es un marco que acelera las cargas de trabajo de IA y KubeRay ayuda a administrar estas cargas en Kubernetes. CodeFlare es fundamental para las capacidades de cargas de trabajo distribuidas de Red Hat OpenShift AI debido a que proporciona un marco sencillo que ayuda a simplificar la orquestación y el monitoreo de tareas. Las capacidades centrales de gestión y cola permiten un aprovechamiento óptimo de los nodos y la asignación de recursos, como las GPU, a los usuarios y a las cargas de trabajo correspondientes.

Desarrollo de modelos optimizado, a través de espacios de trabajo del proyecto e imágenes de bancos de trabajo adicionales que proporcionan a los científicos de datos la flexibilidad para usar IDE y kits de herramientas, incluidos VS Code y RStudio, actualmente disponibles como versión tecnológica preliminar, y una CUDA mejorada, para distintos casos de uso y tipos de modelos.

Visualizaciones del monitoreo de modelos, que permiten obtener métricas operativas y de funcionamiento, lo cual mejora la observabilidad del rendimiento de los modelos de IA.

Nuevos perfiles de aceleradores, que permiten a los administradores configurar diferentes tipos de aceleradores de hardware disponibles para el desarrollo de modelos y los flujos de trabajo de servicio de modelos. Esto brinda a los usuarios un acceso sencillo y de autoservicio al tipo de acelerador adecuado para una carga de trabajo específica.

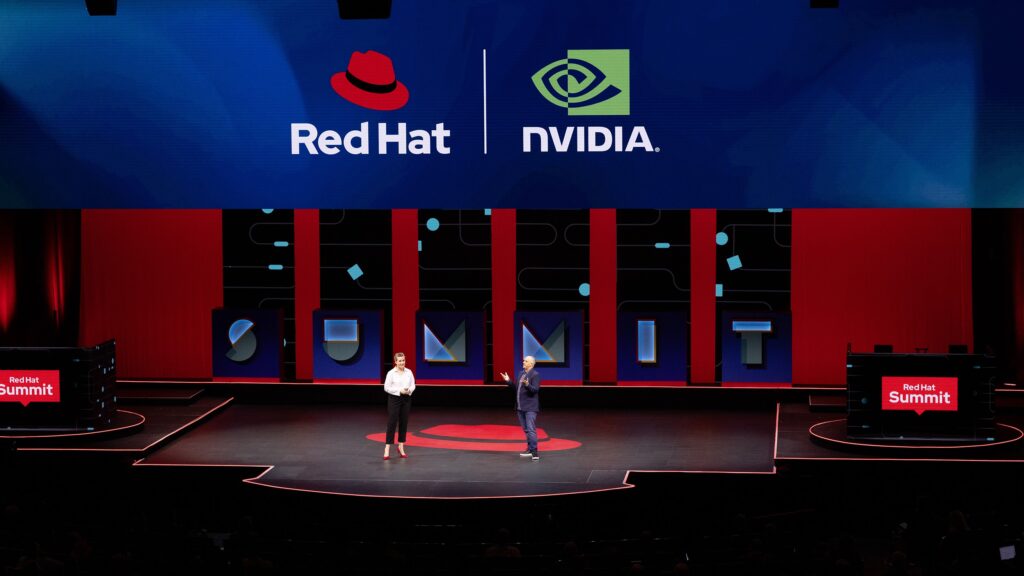

Red Hat presenta NVIDIA NIM Integration en OpenShift AI

Red Hat también anunció el inminente soporte de integración de microservicios NVIDIA NIM en OpenShift AI, que permitirá la inferencia optimizada de docenas de modelos de inteligencia artificial (IA) con el respaldo de una plataforma open source de AI/ML uniforme para la nube híbrida. Las empresas podrán usar OpenShift AI con NVIDIA NIM, un conjunto de microservicios de inferencia fáciles de usar que forman parte de la plataforma de software NVIDIA AI Enterprise, con el fin de acelerar la entrega de aplicaciones de IA generativa (IA gen) y la obtención de valor.

Esta integración promueve el incremento de la productividad de las empresas mediante capacidades de IA gen, como la ampliación del servicio de atención al cliente por medio de asistentes virtuales, el resumen de casos de tickets de TI y la aceleración de operaciones comerciales mediante copilotos específicos de dominio.

Colaboración con Run:ai para optimizar las cargas de trabajo de IA para la nube híbrida

Red Hat anunció la colaboración con Run:ai, líder en optimización y orquestación de la IA, para llevar las capacidades de asignación de recursos de Run:ai a Red Hat OpenShift AI. Esta colaboración permite a las empresas sacar el máximo provecho de los recursos de IA porque agiliza las operaciones de IA y optimiza la infraestructura subyacente. De este modo, potencia los flujos de trabajo impulsados tanto por humanos como por hardware en una plataforma de MLOps de confianza para crear, ajustar, implementar y monitorear aplicaciones y modelos con capacidad de IA a gran escala.

Las GPU son los motores informáticos que impulsan los flujos de trabajo de la IA y permiten el entrenamiento de modelos, la inferencia y la experimentación, entre otras cosas. Sin embargo, estos procesadores especializados pueden ser costosos, en particular cuando se los utiliza en tareas de entrenamiento e inferencia distribuidas. Red Hat y Run:ai aunaron sus esfuerzos para atender esta necesidad crítica de optimizar los recursos de GPU a través del OpenShift Operator certificado de Run:ai en Red Hat OpenShift AI, que ayuda a los usuarios a escalarse dondequiera que estén sus cargas de trabajo de IA.