Jensen Huang, CEO de NVIDIA, presentó en la conferencia GTC el NVIDIA Blackwell, los microservicios de NIM, las API de Omniverse Cloud, entre otras soluciones que ponen al fabricante entre los líderes del desarrollo tecnológico.

Jensen Huang presentó la nueva plataforma de computación Blackwell, mientras describía los principales avances que el aumento de la potencia de cómputo puede ofrecer para todo, desde software hasta servicios, robótica, tecnología médica y más.

Huang habló frente a imágenes masivas en una pantalla 8K de 40 pies de altura, del tamaño de una cancha de tenis, ante una multitud repleta de directores ejecutivos y desarrolladores, entusiastas de la inteligencia artificial y empresarios, que caminaron juntos 20 minutos hasta la arena desde el Centro de Convenciones de San José.

Al ofrecer una actualización masiva a la infraestructura de IA del mundo, Huang presentó la plataforma NVIDIA Blackwell para dar rienda suelta a la IA generativa en tiempo real en modelos de lenguaje de un billón de parámetros.

Huang presentó NVIDIA NAM, una referencia a los microservicios de inferencia de NVIDIA, una nueva forma de empaquetar y entregar software que conecta a los desarrolladores con cientos de millones de GPU para implementar IA personalizada de todo tipo. Y al llevar la IA al mundo físico, Huang presentó las API de Omniverse Cloud para ofrecer capacidades de simulación avanzadas.

Huang puntuó estos importantes anuncios con poderosas demostraciones, asociaciones con algunas de las empresas más grandes del mundo y más de una veintena de anuncios que detallan su visión.

La conferencia GTC, que en 15 años ha pasado de ser el salón de baile de un hotel local a la conferencia de IA más importante del mundo, regresa a un evento físico por primera vez en cinco años.

La de este año tuvo más de 900 sesiones, incluida una mesa redonda sobre transformadores moderada por Huang con los ocho pioneros que desarrollaron por primera vez la tecnología, más de 300 exposiciones y más de 20 talleres técnicos.

Es un evento que está en la intersección de la IA y casi todo. En un impresionante acto de apertura de la presentación, Refik Anadol, el artista de IA líder en el mundo, mostró una enorme escultura de datos de IA en tiempo real con remolinos en forma de olas en verdes, azules, amarillos y rojos, chocando, retorciéndose y deshaciéndose a través de la pantalla.

Al iniciar su charla, Huang explicó que el auge de la IA multimodal, capaz de procesar diversos tipos de datos manejados por diferentes modelos, le da a la IA una mayor adaptabilidad y poder. Al aumentar sus parámetros, estos modelos pueden manejar análisis más complejos.

Pero esto también significa un aumento significativo en la necesidad de potencia de cómputo. Y a medida que estos sistemas colaborativos y multimodales se vuelven más complejos, con hasta un billón de parámetros, la demanda de infraestructura informática avanzada se intensifica.

«Necesitamos modelos aún más grandes», dijo Huang. «Vamos a entrenarlo con datos multimodales, no solo texto en Internet, vamos a entrenarlo con textos e imágenes, gráficos y tablas, y así como aprendimos viendo televisión, va a haber un montón de videos».

La próxima generación de computación acelerada

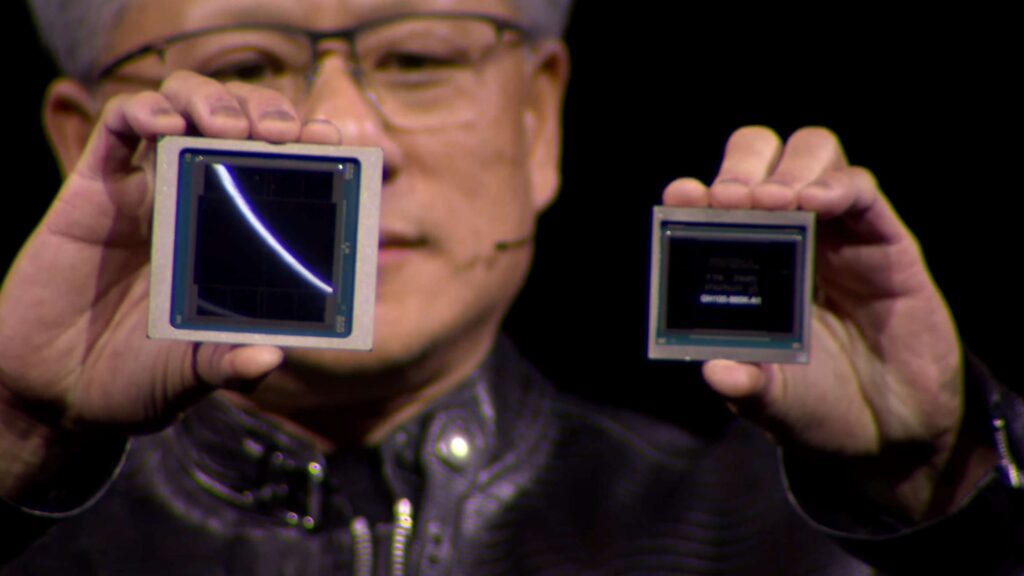

En resumen, Huang dijo que «necesitamos GPU más grandes». La plataforma Blackwell está diseñada para hacer frente a este desafío. Huang sacó una ficha Blackwell de su bolsillo y la sostuvo junto a una ficha Hopper, que empequeñeció.

Nombrada en honor a David Harold Blackwell, un matemático de la Universidad de California, Berkeley especializado en teoría de juegos y estadística, y el primer académico negro incluido en la Academia Nacional de Ciencias, la nueva arquitectura sucede a la arquitectura NVIDIA Hopper, lanzada hace dos años.

Blackwell ofrece 2,5 veces el rendimiento de su predecesor en FP8 para entrenamiento, por chip, y 5 veces con FP4 para inferencia. Cuenta con una interconexión NVLink de quinta generación que es dos veces más rápida que Hopper y escala hasta 576 GPU.

Y el superchip NVIDIA GB200 Grace Blackwell conecta dos GPU Blackwell NVIDIA B200 Tensor Core a la CPU NVIDIA Grace a través de una interconexión de chip a chip NVLink de ultra bajo consumo de 900 GB/s.

Huang levantó un tablero con el sistema. «Esta computadora es la primera de su tipo en la que cabe tanta computación en un espacio tan pequeño», dijo Huang. «Dado que esto es coherente con la memoria, se sienten como si fuera una gran familia feliz trabajando juntos en una aplicación».

Para obtener el máximo rendimiento de IA, los sistemas con tecnología GB200 se pueden conectar con las plataformas Ethernet NVIDIA Quantum-X800 InfiniBand y Spectrum-X800, también anunciadas hoy, que ofrecen redes avanzadas a velocidades de hasta 800 Gb/s.

«La cantidad de energía que ahorramos, la cantidad de ancho de banda de red que ahorramos, la cantidad de tiempo perdido que ahorramos será tremenda», dijo Huang. «El futuro es generativo… Es por eso que esta es una industria completamente nueva. La forma en que calculamos es fundamentalmente diferente. Creamos un procesador para la era de la IA generativa».

Para ampliar Blackwell, NVIDIA creó un nuevo chip llamado NVLink Switch. Cada uno puede conectar cuatro interconexiones NVLink a 1,8 terabytes por segundo y eliminar el tráfico mediante la reducción dentro de la red.

NVIDIA Switch y GB200 son componentes clave de lo que Huang describió como «una GPU gigante», la NVIDIA GB200 NVL72, un sistema de múltiples nodos, refrigerado por líquido y a escala de rack que aprovecha Blackwell para ofrecer computación sobrealimentada para modelos de billones de parámetros, con 720 petaflops de rendimiento de entrenamiento de IA y 1,4 exaflops de rendimiento de inferencia de IA en un solo rack.

«Solo hay un par, tal vez tres máquinas exaflop en el planeta mientras hablamos», dijo Huang sobre la máquina, que empaca 600.000 piezas y pesa 3.000 libras. «Por lo tanto, este es un sistema de IA exaflop en un solo rack. Bueno, echemos un vistazo a la parte de atrás».

Yendo aún más lejos, NVIDIA también anunció su supercomputadora de IA de próxima generación, la NVIDIA DGX SuperPOD impulsada por NVIDIA GB200 Grace Blackwell Superchips, para procesar modelos de billones de parámetros con un tiempo de actividad constante para cargas de trabajo de inferencia y entrenamiento de IA generativa a gran escala.

Con una nueva arquitectura de báscula de rack refrigerada por líquido altamente eficiente, el nuevo DGX SuperPOD está construido con sistemas NVIDIA DG GB200 y proporciona 11,5 exaflops de supercomputación de IA con precisión FP4 y 240 terabytes de memoria rápida, escalando a más con racks adicionales.

«En el futuro, se va a pensar en los centros de datos… como fábricas de IA», dijo Huang. «Su objetivo en la vida es generar ingresos, en este caso, inteligencia».

Blackwell está siendo adoptado por todos los principales proveedores globales de servicios en la nube, empresas pioneras de IA, proveedores de sistemas y servidores, y proveedores regionales de servicios en la nube y empresas de telecomunicaciones de todo el mundo.

«Toda la industria se está preparando para Blackwell», que según Huang sería el lanzamiento más exitoso en la historia de la compañía.

Una nueva forma de crear software

«La IA generativa cambia la forma en que se escriben las aplicaciones», dijo Huang.

En lugar de escribir software, explicó, las empresas ensamblarán modelos de IA, les darán misiones, darán ejemplos de productos de trabajo, revisarán planes y resultados intermedios.

Estos paquetes, los NVIDIA NIM, se construyen a partir de las bibliotecas de computación acelerada y los modelos de IA generativa de NVIDIA, explicó Huang.

«¿Cómo construimos software en el futuro? Es poco probable que lo escribas desde cero o escribas un montón de código Python o algo así», dijo Huang. «Es muy probable que reúnas un equipo de IA».

Los microservicios son compatibles con las API estándar de la industria, por lo que son fáciles de conectar, funcionan en toda la gran base instalada de CUDA de NVIDIA, se reoptimizan para nuevas GPU y se analizan constantemente en busca de vulnerabilidades y exposiciones de seguridad.

Huang dijo que los clientes pueden usar los microservicios de NIM listos para usar, o NVIDIA puede ayudar a construir IA y copilotos patentados, enseñando a un modelo habilidades especializadas que solo una empresa específica conocería para crear nuevos servicios invaluables.

«La industria de TI empresarial está sentada sobre una mina de oro», dijo Huang. «Tienen todas estas increíbles herramientas (y datos) que se han creado a lo largo de los años. Si pudieran tomar esa mina de oro y convertirla en copilotos, estos copilotos pueden ayudarnos a hacer cosas».

Los principales actores tecnológicos ya lo están poniendo a trabajar. Huang detalló cómo NVIDIA ya está ayudando a Cohesity, NetApp, SAP, ServiceNow y Snowflake a construir copilotos y asistentes virtuales. Y las industrias también están interviniendo.

En el sector de las telecomunicaciones, Huang anunció NVIDIA 6G Research Cloud, una plataforma impulsada por IA generativa y Omniverse para avanzar en la próxima era de las comunicaciones. Está construido con el marco de radio neuronal Sionna de NVIDIA, la red de acceso de radio acelerada por NVIDIA Aerial CUDA y el gemelo digital NVIDIA Aerial Omniverse para 6G.

En el diseño y la fabricación de semiconductores, Huang anunció que, en colaboración con TSMC y Synopsys, NVIDIA está llevando a producción su innovadora plataforma de litografía computacional, cuLitho. Esta plataforma acelerará la carga de trabajo más intensiva en computación en la fabricación de semiconductores entre 40 y 60 veces.

Huang también anunció el gemelo digital NVIDIA Earth Climate. La plataforma en la nube, ya disponible, permite la simulación interactiva de alta resolución para acelerar la predicción climática y meteorológica.

El mayor impacto de la IA será en el cuidado de la salud, dijo Huang, explicando que NVIDIA ya está en los sistemas de imágenes, en los instrumentos de secuenciación de genes y trabajando con las principales empresas de robótica quirúrgica.

NVIDIA está lanzando un nuevo tipo de software de biología. NVIDIA ha lanzado más de dos docenas de nuevos microservicios que permiten a las empresas sanitarias de todo el mundo aprovechar los últimos avances en IA generativa desde cualquier lugar y en cualquier nube. Ofrecen imágenes avanzadas, lenguaje natural y reconocimiento de voz, y generación, predicción y simulación de biología digital.

Omniverse lleva la IA al mundo físico

La próxima ola de IA será el aprendizaje de la IA sobre el mundo físico, dijo Huang.

«Necesitamos un motor de simulación que represente el mundo digitalmente para el robot, de modo que el robot tenga un gimnasio para aprender a ser un robot», dijo. «A ese mundo virtual lo llamamos Omniverse».

Es por eso que NVIDIA anunció hoy que NVIDIA Omniverse Cloud estará disponible como API, ampliando el alcance de la plataforma líder en el mundo para crear aplicaciones y flujos de trabajo de gemelos digitales industriales en todo el ecosistema de fabricantes de software.

Las cinco nuevas interfaces de programación de aplicaciones de Omniverse Cloud permiten a los desarrolladores integrar fácilmente las tecnologías principales de Omniverse directamente en las aplicaciones de software de diseño y automatización existentes para gemelos digitales, o en sus flujos de trabajo de simulación para probar y validar máquinas autónomas como robots o vehículos autónomos.

Para mostrar cómo funciona esto, Huang compartió una demostración de un almacén robótico, utilizando la percepción y el seguimiento de múltiples cámaras, vigilando a los trabajadores y orquestando carretillas elevadoras robóticas, que conducen de forma autónoma con la pila robótica completa en funcionamiento.

Huang también anunció que NVIDIA está llevando Omniverse a Apple Vision Pro, con las nuevas API de Omniverse Cloud que permiten a los desarrolladores transmitir información industrial interactiva en los auriculares de realidad virtual.

Algunos de los fabricantes de software industrial más grandes del mundo están adoptando las API de Omniverse Cloud, incluidos Ansys, Cadence, Dassault Systèmes para su marca 3DEXCITE, Hexagon, Microsoft, Rockwell Automation, Siemens y Trimble.

Robótica

Todo lo que se mueva será robótico, dijo Huang. La industria automotriz será una gran parte de eso. Las computadoras NVIDIA ya están en automóviles, camiones, bots de reparto y robotaxis.

Huang anunció que BYD, la compañía de vehículos autónomos más grande del mundo ha seleccionado la computadora de próxima generación de NVIDIA para su AV, construyendo sus flotas de vehículos eléctricos de próxima generación en DRIVE Thor.

Para ayudar a los robots a ver mejor su entorno, Huang también anunció el kit de desarrollo de software Isaac Perceptor con odometría visual multicámara de última generación, reconstrucción 3D y mapa de ocupación, y percepción de profundidad.

Y para ayudar a que los manipuladores, o brazos robóticos, sean más adaptables, NVIDIA anuncia Isaac Manipulator, una biblioteca de percepción, planificación de rutas y control cinemático de brazos robóticos de última generación.

Por último, Huang anunció el Proyecto GR00T, un modelo básico de propósito general para robots humanoides, diseñado para promover el trabajo de la compañía para impulsar avances en robótica e IA incorporada.

Para apoyar ese esfuerzo, Huang dio a conocer una nueva computadora, Jetson Thor, para robots humanoides basada en el sistema en un chip NVIDIA Thor y actualizaciones significativas de la plataforma robótica NVIDIA Isaac.

En sus últimos minutos, Huang subió al escenario un par de diminutos robots impulsados por NVIDIA de Disney Research.

«El alma de NVIDIA: la intersección de los gráficos por computadora, la física y la inteligencia artificial», dijo. «Todo salió a la luz en este momento».